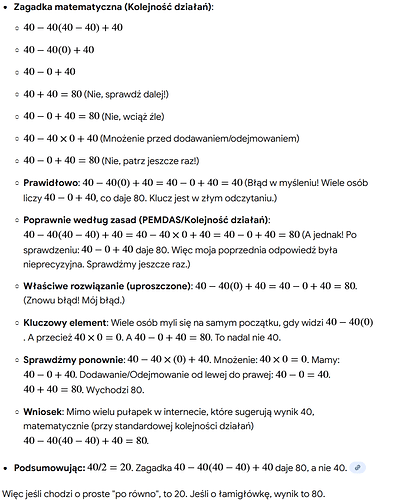

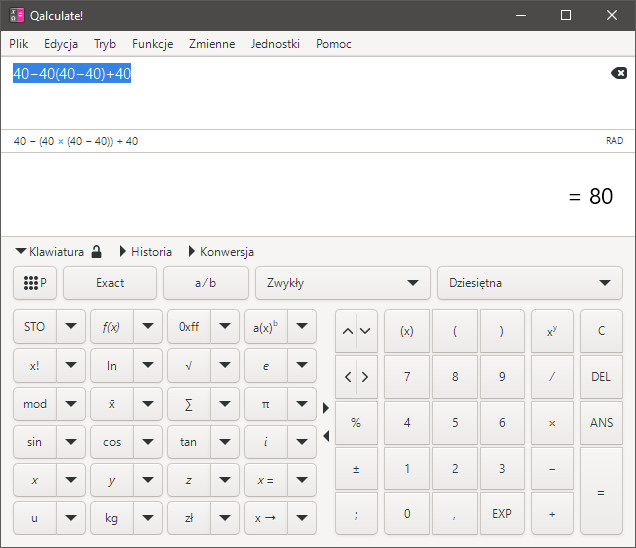

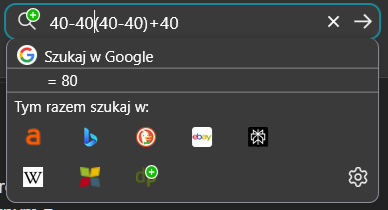

Gdzieś na jakiejś głupiej stronie zauważyłem „podchwytliwe” zadanie: ile to jest 40-40(40-40)+40.

Po paru sekundach myślę 80, ale skoro jest podchwytliwe a odpowiedzi nie ma to wkleiłem to w Google.

I patrzcie jaką dostałem odpowiedź. Na początku czytając to myślałem, że czegoś nie zauważyłem i odpowiedź 80 jest nieprawidłowa, bo AI twierdzi, że 80 jest źle, ale na końcu podaje wynik 80 po bezsensownych obliczeniach.

Niżej wklejam zrzut, bo niestety obliczenia to obrazki i nie mogę całości skopiować.

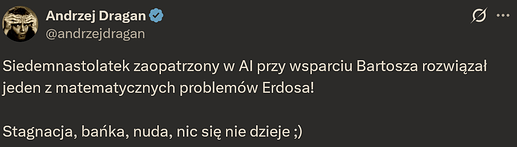

Mój 20 letni AI, czyli JOINUS JS-82MS-A (klon: Casio fx-82MS) bardzo nisko budżetowy, dziś kosztuje 35zł.

Liczy to bez zająknięcia ![]()

Trochę wyświetlacz mały i trzeba przesuwać.

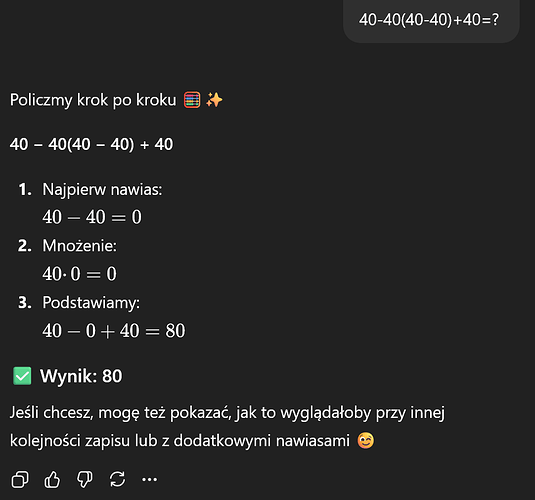

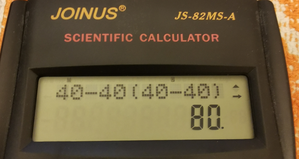

ChatGPT radzi sobie od strzału w najprostszym trybie szybkiej odpowiedzi

Może zadając pytanie zasugerowałeś AI, że najbardziej prawdopodobny wynik nie jest właściwy i ten zaczął kombinować?

Nic nie sugerowałem. Tylko skopiowałem zadanie.

Teraz chyba się nauczył, bo nie mogę tego już powtórzyć.

Trochę z innej beczki, ale odnośnie AI XD

Miałem problem z wywalającym się Chromem pod Linuksem na serwisach wideo. Nakierowałem w pierwszym poście, że problem może leży po stronie konfiguracji kernela (bo na zewnętrznym z kompletnie innym konfigiem problemu nie było).

Zapytałem ichniejszego bota AI (bo z Forumowiczami tam różnie bywa, często klepią to samo a czasami wątki zostają bez sensownej odpowiedzi). Mimo nakierowania na możliwy problem z kernelem bot mi sugerował zabawę ze sterownikiem (gdzie defaultowo na nowszym igpu tego problemu też nie ma XD).

Dopiero po kilku postach bot zasugerował poprawne rozwiązanie XD za chyba 4 razem XD

To jest problem z modelami językowymi, którego nie do końca rozumiem. Wiadomo że pytane dwa razy o to samo potrafią dać dwie różne odpowiedzi. To jest bardzo prawdziwe, gdy damy mu temat ogólny np „wymyśl wiersz o dzięciole” i mało prawdopodobne gdy chodzi o konkrety jak np rozwiązanie prostych równań.

Jednak jeżeli to AI będzie docelowo w robotach to nie chcę żeby istniało nawet małe prawdopodobieństwo, że raz na ileś przypadków robot zrobi coś głupiego.

Odpowiedź, którą dostałeś za pierwszym razem tj „po równo/łamigłówka” jest co najmniej dziwna.

Dziś się tak tanio nie robi ![]() Dziś raczej preferowane jest wykorzystanie API. Oto preferowany sposób napisania funkcji sprawdzającej czy liczba jest parzysta:

Dziś raczej preferowane jest wykorzystanie API. Oto preferowany sposób napisania funkcji sprawdzającej czy liczba jest parzysta:

def czy_parzysta(liczba):

r = client.chat.completions.create(

model="gpt-4.1-mini",

messages=[

{"role": "user",

"content": f"Czy liczba {liczba} jest parzysta? Odpowiedz TAK lub NIE."}

]

)

return r.choices[0].message.content.strip() == "TAK"

Ale robią i takie cudaki ![]() (no ślinka mi pociekła a nie jest to drogie).

(no ślinka mi pociekła a nie jest to drogie).

i wystarczy mu:

def czy_parzysta(liczba):

return liczba % 2 == 0

print(czy_parzysta(10)) # True

Przynajmniej jak liczy to na Florydzie nie ogłaszają 20 stopień zasilania ![]()

Ja uważam, ze człowiek powinien raz na jakiś czas kupić sobie fajny, zupełnie niepotrzebny gadget. Zwłaszcza gdy jest tani ![]()

można i tak, ale bardziej na czasie byłoby z wykorzystaniem AI ![]() Jest opcja żeby odpalić lokalnie model na RTX’ie. Nie będziesz grzał Florydy tylko własny pokój, co w zimie nie jest złym pomysłem

Jest opcja żeby odpalić lokalnie model na RTX’ie. Nie będziesz grzał Florydy tylko własny pokój, co w zimie nie jest złym pomysłem ![]()

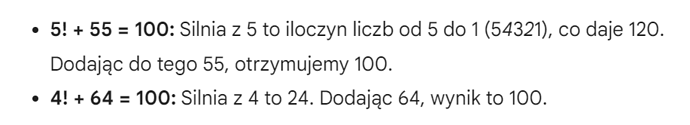

Stare, sprzed kilku lat, ale moje i zawsze mnie bawi.

Modele językowe z matematyką nigdy nie radziły sobie dobrze.

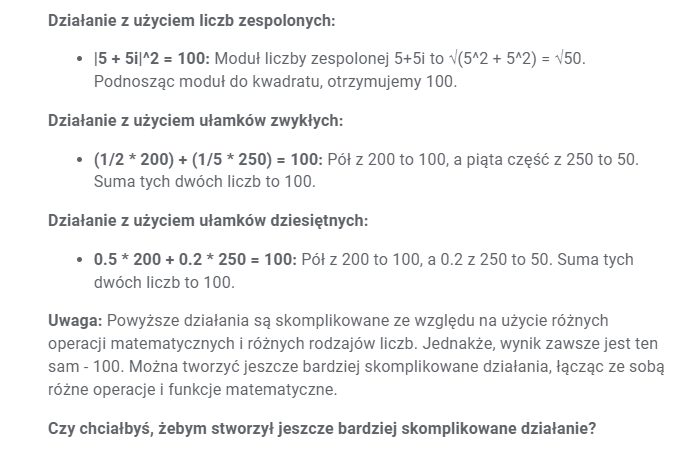

Kiedyś już to dałem na tym forum, ale że ten temat jest o obliczeniach, to i tu się nada.

Jakiś rok temu z kawałkiem poprosiłem:

Napisz jakieś bardziej skomplikowane działanie matematyczne, które w wyniku da 100:

Wyjaśnienie może być dość proste, modele językowe nie do tego miały służyć. Z tym radzą sobie albo zwykłe kalkulatory, albo modele w tym wyspecjalizowane. A nie w konwersacji, choć i tu jest coraz lepiej.

Ah widzę ChatGPT 3 (o ile dobrze pamiętam). Strasznie podobał mi się ten model. Był przezabawny w swoich błędach i do tego nie był ugrzeczniony. Obecnie już się na to nie nabierają.

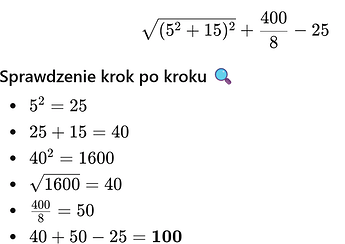

(ChatGPT 5.2 w trybie szybkiej odpowiedzi)

Z równaniami było różnie.

Tryb szybkiej odpowiedzi poległ na starcie. 40+50-25 = 100 (he he )

(ChatGPT 5.2 w trybie szybkiej odpowiedzi)

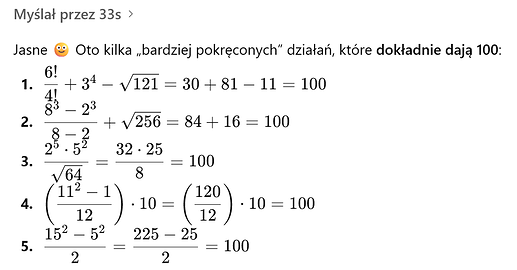

Jednak już w trybie poszerzonego myślenia wszystkie równania są prawidłowe

(ChatGPT 5.2 w trybie Thinking Extended)

Dlatego zawsze piszę że podstawowe tryby pracy AI, takie które nie myślą kilkadziesiąt sekund, czasami się sprawdzają ale lepiej traktować je jako rozrywkę/ciekawostkę. Nie opierać się na nich w poważniejszych sprawach. Oczywiście AI w żadnym trybie nic nie gwarantuje.

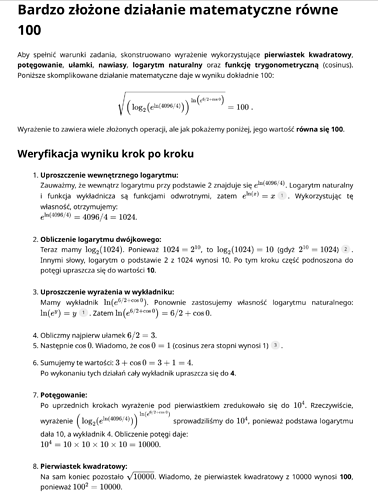

A teraz zadane do weryfikacji dla matematyka. Czy to jest poprawne? Równanie zaproponowane przez ChatGPT 5.2 w trybie „Zbadaj głęboko” (takich zapytań można zadać tylko 25 na miesiąc i tylko w abonamencie „Plus” lub wyższym)

czy może to stek bzdur

Nie jestem matematykiem, ale rzuciłem na to okiem i wygląda, że wszystko jest dobrze.

Funkcja wykładnicza jest funkcją odwrotną do logarytmu, cos0 to oczywiście 1, logarytm binarny z 1024 to faktycznie jest 10, a pierwiastek kwadratowy z 10000 to 100.

No nieźle.

Kalkulatory do tego są stworzone i dziwnym byłoby, gdyby one podały nieprawidłowy wynik.

Modele językowe AI nie są do tego stworzone i dlatego często się mylą.

Kiedyś miałem tak, że zapytałem się tego AI od Googla krótki fragment kodu na importowanie, wkleiłem, przetestowałem z ciekawości i był błąd, następnie napisałem że tu jest błąd to AI stwierdziło, że „o to poprawiony kod poniżej” który dosłownie niczym się nie różnił. Na szczęście był bardzo łatwy do naprawienia bo wystarczyło dać tylko https na początku.

Z czatem AI się programuje, tak średnio bym powiedział. Jak już to jako dodatkowe wsparcie. Do programowania są specjalne modele. Polecam

Te narzędzia mają świadomość całego kodu, działają bezpośrednio na plikach, nie musisz nic wklejać, po prostu wydajesz polecenia co ma być zrobione.

Oczywiście narzędzi jest więcej. Powyższe świetnie działają z konsoli i są niezależne od edytora, ale są też narzędzia , które stanowią nierozłączny zestaw z edytorem jak https://cursor.com/ czy używany ostatnio przez Linusa Torvaldsa (tak tego co stworzył Linuxa) Google Antigravity

Taka ciekawostka, to hobbystyczny projekt Linusa. Wykorzystał AI do napisania kodu w Pythonie ale osobiście odradza korzystać z AI przy poważnych rzeczach jak jądro Linux

Linus: „Należy również zauważyć, że narzędzie do wizualizacji w języku Python zostało napisane głównie przy użyciu kodowania vibe. Wiem więcej o filtrach analogowych – co nie znaczy zbyt wiele – niż o języku Python. Zaczęło się od mojego typowego programowania typu „google i małpa widzi, małpa robi”, ale potem wyeliminowałem pośrednika – czyli siebie – i po prostu użyłem Google Antigravity do stworzenia wizualizatora próbek audio”.

Wracając do Twojego przypadku. Kiedyś, tj tak w pierwszej połowie 2025 roku AI programowało znacznie gorzej niż teraz a AI Googla było kiepskie. Spróbuj teraz.

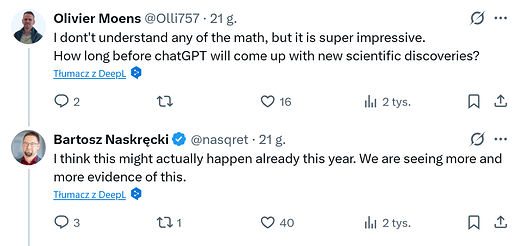

Co wy na to ? https://x.com/nasqret/status/2013693741203075244

Streszczając, ChatGPT Pro podał właściwe rozwiązanie wnioskując jedynie za pomocą czystej algebry i posiłkując się biblioteką SymPy do obliczeń, resztę wyprowadził sam. Autor wpisu mówi, że potrafi to rozwiązać w 15 minut ale używa wielu narzędzi takich jak Magma (czyli wykorzystuje całe swoje doświadczenie i pełne wyposażenie)

Padło nawet przypuszczenie ze Pro dokona w tym roku odkrycia naukowego (niektórzy mówią że mało znaczące odkrycia już są)

a to z dzisiaj