@Wredzia No rzeczywiście, jak się zastosuje porównanie binarne plików to jest to mało czytelne lub po prostu sieczka - masz rację. Oczywiście zakładam, że masz na myśli porównanie binarne plików w WinMerge, a nie w ogóle ?

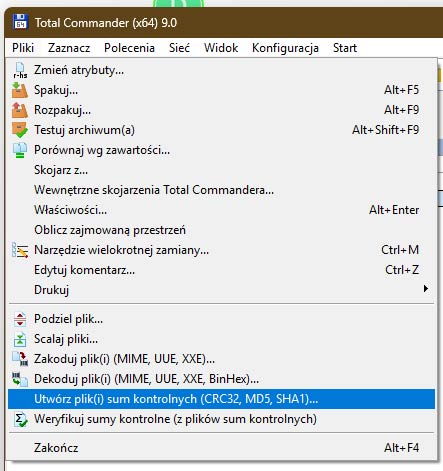

Bo np. porównanie binarne plików wykonuje też chyba komenda fc /b file1 file2 w wierszu poleceń (cmd.exe) oraz opcja „Porównaj wg zawartości…” w Total Commander, dobrze myślę ?

Jak próbowałem porównywać pliki za pomocą komendy fc /b file1 file2 w wierszu poleceń (cmd.exe) to wydaje mi się, że aż takiej sieczki nie było i wyglądało to w miarę czytelnie, bo po zakończeniu porównania plików wyświetlało chyba tylko te miejsca w danych binarnych porównywanych plików gdzie występują różnice między porównywanymi plikami, a nie wszystkie dane binarne porównywanych plików w ogóle, włącznie oczywiście z różnicami w tych danych. W ogóle chyba ta komenda fc /b file1 file2 w wierszu poleceń (cmd.exe) z samego założenia wyświetla właśnie tylko te miejsca w danych binarnych porównywanych plików gdzie występują różnice między porównywanymi plikami, a całej reszty, czyli pozostałego zapisu binarnego porównywanych plików który się pokrywa w porównywanych plikach chyba nie, czy mam rację ? Z kolei jak ta komenda fc /b file1 file2 w wierszu poleceń (cmd.exe) w ogóle nie znajdzie żadnych różnic w danych binarnych porównywanych plików to wówczas w ogóle żadne dane binarne porównywanych plików nie są wyświetlanie po zakończeniu porównywania plików, a pojawia się tylko komunikat, że pliki są identyczne.

W Total Commander z kolei opcja „Porównaj wg zawartości…” działa tak, że jak zostaną znalezione jakieś różnice w danych binarnych porównywanych plików to program wyświetla wprawdzie chyba cały zapis binarny porównywanych plików, ale jednocześnie te miejsca w danych binarnych porównywanych plików gdzie występują różnice między porównywanymi plikami są zapisane czerwoną czcionką, a cała reszta, czyli pozostały zapis binarny porównywanych plików który się pokrywa w porównywanych plikach jest domyślnie zapisany normalnie czarną czcionką. Z tym, że tu chyba znowu UWAGA ! Total Commander wprawdzie porównuje pliki porównując ich dane binarne, ale jeśli zostaną znalezione jakieś różnice w danych binarnych porównywanych plików to program wyświetla cały zapis binarny porównywanych plików gdzie tak jak wspomniałem wcześniej - czerwoną czcionką są zapisane te miejsca w danych binarnych porównywanych plików gdzie występują różnice między porównywanymi plikami, a cała reszta, czyli pozostały zapis binarny porównywanych plików który się pokrywa w porównywanych plikach jest domyślnie zapisany normalnie czarną czcionką. ALE - to co program wyświetla, czyli te niby dane binarne porównywanych plików są zapisane w systemie hexadecymalnym/szesnastkowym a nie binarnym/dwójkowym ! Innymi słowy program porównuje pliki porównując ich dane binarne które z samego założenia powinny być zapisane domyślnie/normalnie w systemie binarnym/dwójkowym, a zatem stanowić ciąg zer i jedynek, ale wynik końcowy jest konwertowany w programie z tego domyślnego/normalnego zapisu binarnego/dwójkowego na system hexadecymalny/szesnastkowy, zapewne po to by znacząco skrócić długość potencjalnego horrendalnie długiego zapisu danych binarnych porównywanych plików w domyślnym/normalnym systemie binarnym/dwójkowym. W końcu łatwiej zapisać długi kod danych mając do dyspozycji 16 znaków aniżeli tylko 2 znaki, dobrze kombinuję ? Z kolei jeśli Total Commander w ogóle nie znajdzie żadnych różnic w danych binarnych porównywanych plików to wtedy w ogóle żadne dane binarne porównywanych plików, oczywiście uprzednio przekonwertowane z domyślnego/normalnego zapisu dwójkowego/binarnego na system hexadecymalny/szesnastkowy nie są wyświetlanie po zakończeniu porównywania plików, a pojawia się tylko komunikat, że pliki są identyczne, czyli tak samo jak w przypadku użycia komendy fc /b file1 file 2 w wierszu poleceń (cmd.exe).

@blumberplumber W porządku, rozumiem. W sumie to mnie też chodzi o to samo co Tobie, tzn. dwie kopie danych zapisanych w dwóch różnych miejscach - jedna na wewnętrznym dysku SSD Crucial MX500 4TB tylko na dane w laptopie oraz druga na zewnętrznym dysku SSD Crucial X8 4TB tylko na dane. W ogóle to myślę jeszcze o dwóch dodatkowych kopiach danych zapisanych w kolejnych dwóch różnych miejscach - jedna na drugim wewnętrznym dysku SSD Crucial MX500 4TB tylko na dane w pececie oraz druga na drugim zewnętrznym dysku SSD Crucial X8 4TB tylko na dane. Innymi słowy miałbym wtedy cztery kopie zapisanych danych w czterech różnych miejscach - zawsze jest wówczas większa szansa, że na czymś te dane jednak przetrwają całe i zdrowe, nawet jak któryś dysk/dyski nagle mi nawalą.

Nie wiem czy to najlepszy zestaw do robienia kopii zapasowych, tzn. dwa wewnętrzne dyski SSD Crucial MX500 4TB i dwa zewnętrzne dyski SSD Crucial X8 4TB, a Wy jak sądzicie ? To dobre dyski czy lepiej byłoby zmienić na coś innego, np. coś od Samsunga z takich modeli jak np. 870 EVO, 860 EVO, 860 PRO, T5, T5 EVO, T7, T7 Shield lub T9 lub coś od SanDisk jak np. Ultra 3D, Extreme Portable i Desk Drive ? A może coś od WD, jak np. Red, Blue lub Green albo od Kingstona jak np. SEDC600M, DC600M, DC500ME, XS1000, XS1000R, XS2000 i SXS2000 ? No może jeszcze Patriot, jak np. P210 i P220 ? ADATA, PNY, Verbatim, Goodram i Silicon Power nie są chyba najbardziej godne zaufania jeśli chodzi o ich awaryjność i bezpieczeństwo danych, prawda ? Nie wiem jak Kioxia, OCZ, Emtec, Corsair, Hynix, SK Hynix, Transcend, Seagate, Phison, Lexar, Gigabyte, MSI, ASUS, Acer, Biostar, Intel, Dell, Apple, Lenovo, Netac, Sony, Philips, OWC, Kodak, HP, Fanxiang, itd. - jak u nich jest z awaryjnością i bezpieczeństwem danych, może ktoś się orientuję tutaj ?

@sensu A czym się różni wynajdywanie różnic w plikach od sprawdzania integralności danych ? To nie to samo ?

Tak wiem - duża ściana tekstu, ale tak jakoś wyszło.